Mi az a robots.txt fájl és miért hasznos?

A weboldalak hatékony keresőoptimalizálása (SEO) és a webes tartalom megfelelő indexelése szempontjából a robots.txt fájl egy kulcsfontosságú eszköz. Bár elsőre talán nem tűnik jelentőségteljesnek, a megfelelő konfigurációja segíthet abban, hogy a keresőmotorok – és más automatizált botok, mint például a Facebook scraper – pontosan azt a tartalmat érjék el, amit szeretnél. Ebben a cikkben részletesen bemutatjuk, mi az a robots.txt fájl, hogyan működik, és miért érdemes odafigyelni a beállításaira.

Mi az a robots.txt fájl?

A robots.txt egy egyszerű szöveges fájl, amelyet a weboldalad gyökérkönyvtárában helyezhetsz el (általában a https://yourdomain.com/robots.txt URL-en érhető el). Ez a fájl tájékoztatja a keresőmotorok robotjait (pl. Googlebot, Bingbot) és egyéb automatizált rendszereket arról, hogy mely oldalakat, könyvtárakat szeretnéd indexeltetni, illetve mely részeket szeretnéd kizárni az indexelésből.

Alapvető felépítés

A robots.txt fájlban általában két fő direktíva szerepel:

- User-agent: Ez határozza meg, melyik botra vonatkozik a beállítás.

- Disallow: Ez azt jelzi, hogy mely URL útvonalakat tiltasz meg a megadott bot számára.

Például:

User-agent: *

Disallow:

A fenti példa azt jelenti, hogy minden bot számára engedélyezett az oldal összes része, mert nincs semmilyen tiltás. Ez az alapértelmezett, ha nem szeretnéd korlátozni a tartalom indexelését.

A noindex és index beállítások, valamint a keresőmotor láthatóság

Fontos megérteni, hogy a robots.txt fájl nem közvetlenül szabályozza a noindex vagy index meta tag-eket, azonban befolyásolhatja, hogy a keresőmotorok milyen mértékben látják a tartalmat. Például:

- Meta noarchive címke: Ez megakadályozza, hogy a keresőmotorok a weboldal korábbi változatait (cache) jelenítsék meg.

- Meta noindex címke: Ez azt jelzi, hogy egy adott oldal ne legyen indexelve, függetlenül attól, hogy a robots.txt engedélyezi-e vagy sem.

Ezért nemcsak a robots.txt fájl beállításait, hanem a HTML meta címkéket is érdemes ellenőrizni, ha problémák merülnének fel a gyorsítótárazással vagy az indexeléssel kapcsolatban.

Miért érdemes ellenőrizni a robots.txt fájlt?

A robots.txt fájl helytelen konfigurációja nemcsak a keresőmotorok indexelését befolyásolhatja, hanem más automatizált eszközök, például a Facebook Debugger működését is. A Facebook például a facebookexternalhit nevű bot segítségével próbálja lekérni az oldal tartalmát, hogy a megosztásoknál megfelelő előnézetet (képet, címet, leírást) jelenítsen meg.

Gyakori probléma: A Facebook bot tiltása

Ha a Facebook Debugger azt jelzi, hogy a robots.txt fájlod blokkolja a facebookexternalhit botot, akkor előfordulhat, hogy a megosztott tartalmaknál nem jelenik meg a megfelelő előnézet. A hibaüzenet ilyesmi lehet:

Response Code Reason: This response code could be due to a robots.txt block. Please allowlist facebookexternalhit on your sites robots.txt config to utilize Facebook scraping

Ez azt jelenti, hogy a Facebook botja nem fér hozzá az oldal tartalmához a robots.txt konfiguráció miatt.

Hogyan ellenőrizd és módosítsd a robots.txt fájlodat?

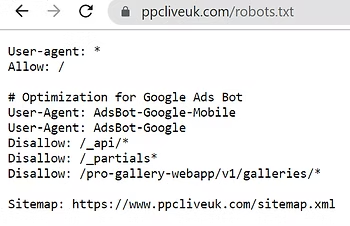

1. Ellenőrizd a robots.txt fájlt

Ha hozzáférsz a weboldaladhoz, ellenőrizd a következőket:

- Közvetlen hozzáférés: Nyisd meg a böngésződben az https://yourdomain.com/robots.txt URL-t, és nézd meg a tartalmát.

- HTML meta címkék: Ellenőrizd a HTML kódot a noarchive és noindex meta címkék esetében, mert ezek akadályozhatják a gyorsítótárazást vagy az indexelést.

2. Ellenőrizd a Facebook bot állapotát

Ha a Facebook Debugger azt jelzi, hogy a facebookexternalhit bot tiltva van, akkor a következő lépéseket kell követned:

Nyisd meg a robots.txt fájlodat. Ha nem találod, általában az alábbi URL-en érhető el:

https://yourdomain.com/robots.txt

Ellenőrizd, hogy van-e tiltás a Facebook botja számára. Ha a fájlban az alábbi bejegyzést látod, a Facebook bot tiltva van:

User-agent: facebookexternalhit

Disallow: /

3. Engedélyezd a Facebook botját

Ha a Facebook botja tiltva van, vagy nincs kifejezetten engedélyezve, akkor módosítsd a fájlt az alábbiak szerint:

Közvetlen engedélyezés a Facebook bot számára:

User-agent: facebookexternalhit

Allow: /

Ha minden bot számára engedélyezni szeretnéd a hozzáférést:

User-agent: *

Allow: /

Miután elvégezted a szükséges módosításokat, mentsd el a robots.txt fájlt, és töltsd fel a szerverre.

További lépések a robots.txt fájl frissítése után

1. Facebook cache törlése

A módosítások után érdemes frissíteni a Facebook cache-ét, hogy a legújabb beállítások érvénybe lépjenek:

- Látogass el a Facebook Debugger oldalára.

- Add meg a weboldalad URL-jét.

- Kattints a Scrape Again gombra, hogy a Facebook újra beolvassa az oldal tartalmát.

2. Egyéb ellenőrzések

Ha továbbra is gond van a tartalom megjelenítésével, ellenőrizd a szerver beállításait, illetve a .htaccess fájlt, mert azokban is lehetnek olyan szabályok, amelyek tiltják a botok hozzáférését.

Összegzés

A robots.txt fájl egy rendkívül hasznos eszköz, amely segít szabályozni, hogy mely részeit indexeljék a keresőmotorok, illetve milyen módon férjenek hozzá az oldal tartalmához különböző botok. Megfelelő konfigurációval biztosíthatod, hogy a weboldalad optimalizált legyen a keresőmotorok számára, és a közösségi média platformok – például a Facebook – is megfelelően tudják előnézeti információkkal megjeleníteni a tartalmaidat.

Ne feledd, hogy a robots.txt mellett figyelned kell a HTML meta noarchive és noindex címkékre is, mivel ezek is befolyásolhatják a tartalom indexelését és a gyorsítótárazást. Ha a Facebook bot (facebookexternalhit) tiltva van, a megfelelő módosításokkal (például a fenti kódblokkok használatával) engedélyezheted számára a hozzáférést, így elkerülheted, hogy a megosztásoknál hiányozzanak a kívánt előnézeti adatok.

A robots.txt fájl rendszeres ellenőrzése és karbantartása része a weboldalad technikai optimalizációjának, ami hosszú távon hozzájárul a jobb felhasználói élményhez és a hatékonyabb keresőoptimalizáláshoz. Ha bármilyen kérdésed vagy problémád adódna, ne habozz konzultálni a webtárhely szolgáltatóddal vagy egy szakértővel!

Related Posts

Vélemény, hozzászólás? Válasz megszakítása

Legutóbbi bejegyzések

- 6 dolog, amit a gyorsan növekvő cégek minden nap másként csinálnak

- Hogyan használd a Google Trends-et, hogy mindig jókor legyél jó helyen

- Webshop indítás a nulláról: hogyan építs láthatóságot, forgalmat és bizalmat az első évben (anélkül, hogy feladnád félúton)

- Elvesztél a marketing rövidítések tengerében? Most végre érthetően elmagyarázzuk, mit jelentenek – PPC, CTR, ROAS, CPC

- Mi az a dropshipping? Az online kereskedelem legkényelmesebb modellje

Kategóriák

- Design (13)

- Email marketing (9)

- Grafikai tervezés (18)

- Hasznos (88)

- Ingyen weboldal (1)

- Keresőoptimalizálás (30)

- Marketing (69)

- SEO (32)

- Social media (41)

- Tárhely (9)

- Vállalkozás (49)

- Weblapkészítés (41)

- Webshop (27)

- WordPress (29)